Nach dem eigentlich ungeplant Folge 1 des Lernprojekts veröffentlich wurde. Ungeplant weil es ursprünglich nur eine Testpost um eine upvote via API zu testen war - deswegen auch der Hashtag #test.

Ich habe regelmäßig unter GitHub die Änderungen im Projekt gepusht, so dass jeder den Fortschritt selber begutachten könnte. Könnte weil wen interessiert schon was für einen Bockmist ich hier fabriziere :)

Aktueller Stand ist, dass ich eine Liste von testaccounts via API einlesen (die allgemeinen Accountdaten und die Historydaten) und ein einer MongoDB ablegen.

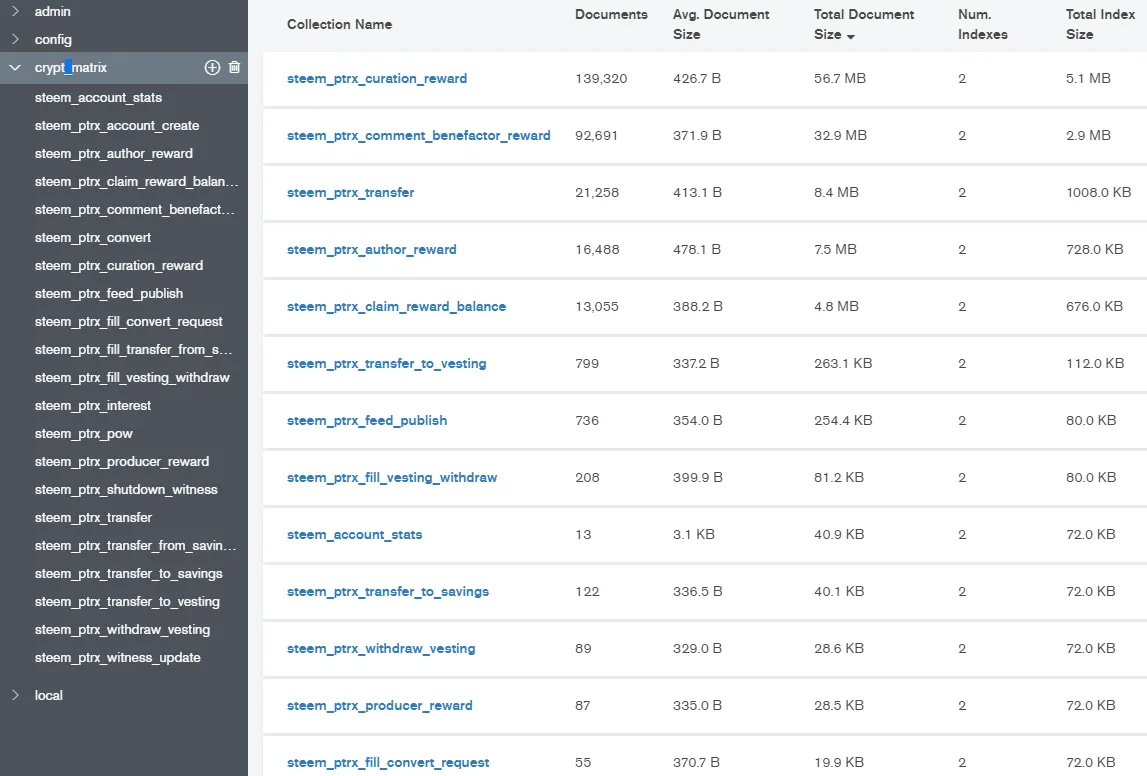

Die MongoDB läuft unter Ubuntu 17 (eigentlich sind nur LTS Versionen supoorted aber egal es läuft). Wenn Ihr das setup nachbauen solltet vergesst nicht die FireWall freizusschalten (port 27017 für die DB connection). Unter windows noch eine instanz installiert nutze dort aber nur den MongoDB compass (viewer/editor siehe Bild unten).

Ursprüchlich dachte ich das Volumen wird mir das Genick brechen, dass tut es aber aktuell gar nicht. Es sind mit ca. 10 großen Accounts nur ca. 100MB. Was mich eher an den Rand des Wahnsinns bringt ist das asynchrone Programmieren mit Callbacks (Rückruf). Also nicht etwas so etwas wie ergbnis=holediedaten() wo holediedaten die Daten als Rückgabewert zurckgibt und man in der nächste Zeile damit weiterarbeiten kann.

Mit Rückrufen (Callbacks) sieht das dann in etwa so aus. holediedaten(meineRuckrufFunktion). Sieht auf den ersten blick einfach aus - der Knackpunkt meineRuckrufFunktion wird irgendwann mal gerufen und man muss eben dort weiterarbeiten.

OK wo stehen wir denn nun?

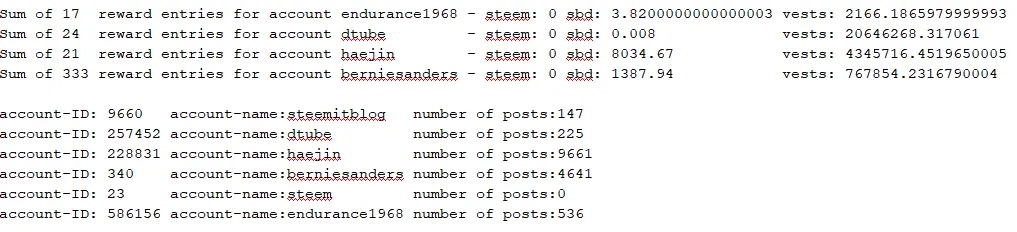

Anwort: die Grundlagen um etwas wie z.B. @taxguy in seinem Post vorgestellt hat sind gelegt. Alle Daten können beschafft werden. Zum Beispiel hier mal eine einfach Testausgabe (claims im Mai 2018 von ein paar bekannten accounts):

Nächster Schritt Ausgabe in eine CSV und HTLM damit man es z.B. in Excel verwenden kann. Nebenbei muss noch eine Währungsumrechnung rein. Danach gibt es dann Grafiken und Auswertungen der Daten.